在这项工作中,我们提出了一种简单而有效的视觉指令调优扩展——视觉预测指令调优(VPiT),它使预训练的LLM能够迅速转变为统一的自回归模型,该模型能够生成文本和视觉标记。VPiT教会LLM从任何以指令遵循格式策划的图像和文本数据的输入序列中预测离散文本标记和连续视觉标记。我们的实证研究揭示了VPiT的几个有趣特性:(1)随着视觉理解的提升,视觉生成能力自然涌现,并且可以通过少量生成数据进行有效解锁;(2)虽然我们发现理解和生成是相互促进的,但理解数据对两种能力的贡献比生成数据更为有效。在这些发现的基础上,我们训练了我们的元形态模型,并在视觉理解和生成方面取得了有竞争力的表现。在视觉生成中,MetaMorph可以利用从大型语言模型预训练中获得的世界知识和推理能力,并克服其他生成模型常见的失败模式。我们的结果表明,大型语言模型可能具有强大的“先验”视觉能力,可以通过相对简单的指令调整过程高效地适应于视觉理解和生成。

1 引言

多模态大型语言模型(MLLMs)在视觉理解方面取得了显著进步,从基本的图片标注发展到复杂的视觉推理(Alayrac等人,2022年;Liu等人,2023年;Dai等人,2024年)。这些模型处理多模态输入——主要是图像和语言,并生成文本标记。多模态大型语言模型通常会利用预训练的视觉编码器(Dosovitskiy等人,2021年;Radford等人,2021年),一个预训练的语言模型(Touvron等人,2023年;AI@Meta,2024年),并通过诸如MLP(Liu等人,2023年,2024a)或交叉注意力模块(Alayrac等人,2022年;Dai等人,2024年)之类的连接器对这些模态进行对齐。在多模态大型语言模型的训练方法中,视觉指令调整(Liu等人,2023年)已被广泛使用(Wang等人,2024a年;Agrawal等人,2024年)。它将预训练视觉编码器的输出嵌入视为连续值的“视觉标记”,并直接将其作为输入提供给预训练的大型语言模型。

视觉指令调整的一个好处是它既节省数据又节省计算资源。一个预训练的LLM可以通过使用数百万对图像-文本问答对的适度计算和数据进行指令调整,被重新用作一个多模态LLM(Tong等人,2024a;Li等人,2024a)。视觉指令调整的有效性表明,LLM已经拥有相当数量的内在视觉知识,这使它们能够在指令调整过程中高效地学习和发展视觉理解(Zhou等人,2024a)。受此启发,我们研究LLM是否也能微调以生成具有相当效率和有效性的视觉信息。

目前针对“统一”模型的尝试——能够进行多模态理解和生成的模型——通常将视觉生成视为与视觉理解正交的能力。它们往往需要对原始的多模态语言模型架构进行大量更改,并进行重要的多模态预训练和/或微调。设计这些方法具有挑战性,以往的研究采用了不同的方法,包括分词

图1 VPiT训练、推理及MetaMorph示例。左图:在视觉预测指令调优(VPiT)中,我们对预训练的LLM进行微调,使其能够使用独立的文本和视觉头部生成文本和视觉令牌。中图:在推理过程中,模型接受任意的图像和文本输入序列,并输出离散的文本令牌和连续的视觉令牌。这些视觉令牌可以通过单独微调的扩散模型进行可视化,该模型被训练为根据预训练的视觉编码器的输出来调整。右图:使用VPiT训练的MetaMorph的一段示例对话。在这里,模型隐式解决了一个视觉谜题,以生成蝴蝶的视觉令牌。随着模型继续自回归地处理视觉和文本令牌,对话继续进行,与基于扩散的可视化无关。

将视觉输入转换为离散令牌(Wu等人,2024b;团队,2024;Liu等人,2024c),结合扩散目标(Xie等人,2024;Zhou等人,2024b),并将视觉分离为独立理解和生成模式(Wu等人,2024a)。例如,像LWM(Liu等人,2024c)、Show-o(Xie等人,2024)和变色龙(团队,2024)这样的方法需要数十亿张图像-文本对(Schuhmann等人,2022;Gadre等人,2024)进行广泛的预训练和微调。

在这项工作中,我们提出了视觉预测指令调优(VPiT)——一种对视觉指令调优的简单扩展,它基于现有的将连续视觉令牌作为输入传递给LLM的模式。VPiT在微调阶段训练大型语言模型(LLM)输出连续的视觉标记和离散的文本标记。该模型以预训练的视觉编码器嵌入以及文本标记作为输入,并输出文本标记和连续视觉标记的组合。为了可视化生成的视觉标记,我们微调了一个扩散模型,将嵌入映射回像素空间(示例见图1)。这一框架使我们能够研究视觉理解、视觉生成与预训练LLM之间的协同作用,从而得出几个有趣的发现,下面将概述。

首先,我们展示了预测视觉标记的能力源于对视觉输入的理解,并且需要最少的额外训练。与视觉指令调整类似,VPiT高效地将大型语言模型转变为一个“统一”的模型,该模型能够理解和生成多模态标记。当与充足的视觉理解数据联合训练时,这个过程仅需额外20万条视觉生成数据。

我们进一步证实,理解和生成视觉标记的能力本质上是相互联系且不对称的。具体来说,增加理解数据会提高视觉理解(通过更高的视觉问答分数来衡量)和生成性能(通过更低的Fréchet Inception Distance分数来衡量)。相反,增加生成数据可以提高生成质量,并且也有助于更强的视觉理解——但程度较小。重要的是,我们的发现突显了一个不对称性……训练每种能力对模型整体视觉性能的影响存在差异:以理解为中心的训练在提高视觉理解和生成方面显著优于以生成为中心的训练。

在这些发现的基础上,我们训练了一个名为MetaMorph的统一模型,使用VPiT来预测多模态标记。我们利用了从常见的视觉问答数据集到纯图像和视频数据(无文本注释)的多样化数据源。MetaMorph在视觉理解和视觉生成基准测试中都取得了有竞争力的表现。此外,我们展示了这种统一建模方法允许模型利用大型语言模型(LLM)的力量。例如,MetaMorph可以在生成视觉标记时从预训练的LLM中提取知识。更令人惊讶的是,我们观察到MetaMorph可以在生成视觉标记之前隐式地执行推理步骤——例如,当提示“由毛毛虫变态而成的动物”时,MetaMorph成功生成了蝴蝶的图像(图1)。

我们的结果表明,1)用指令调整训练统一模型是可行的,以及2)大型语言模型具有强大的预先存在的视觉能力,与广泛预训练相比,可以使用较少的样本激活这些能力。这些见解为混合模式模型的发展提供了启示。随着社区继续提升多模态大型语言模型的视觉理解能力(汤等人,2024a;王等人,2024a;李等人),通过推进基础大型语言模型、指令调整技术和数据,我们强调这些努力也可能隐含地导致在视觉生成方面表现更好的模型。

2 视觉预测指令调整

由LLaVA(刘等人,2023年)引入的视觉指令调整展示了大型语言模型可以被教会理解视觉输入。这是通过对百万级数据进行微调来实现的。晚期融合指令调整的成功表明大型语言模型可能已经具备了固有的视觉理解能力。这种能力只需通过轻量级微调就能解锁。类似地,我们假设大型语言模型已经具备了一定程度的固有视觉生成能力,只需通过轻量级微调就能解锁。

受此启发,我们提出了视觉预测指令调整(VPiT,图1)——一种简单的设计,它扩展了现有的指令调整方法,以额外生成视觉标记而不是单独的文本。我们使用相同的架构和下一个标记预测范式来解锁视觉生成能力,而不需要花哨的功能。我们取一个预训练的大型语言模型,并对其进行微调,使其能够预测离散文本标记和连续视觉标记。视觉标记可以通过适应的扩散模型进行可视化。

2.1 从单模态到多模态下一个标记预测

标准的指令调整设置包括对话轮次输入序列(魏等人,2022a;陶里等人,2023年):(Pi,Ri),其中Pi和Ri分别代表第i轮对话的提示和响应。该模型被训练用来基于提示生成响应。VPiT在标准指令微调设置中增加了以下机制,以解锁视觉理解和生成能力。

对多模态数据进行分词。我们将Pi和Ri扩展为包括文本和图像。为了将视觉数据整合进预训练的LLM,我们紧密遵循视觉指令微调(刘等人,2023年)来处理数据:

● 文本数据:文本被分词成由LLM使用的标准分词器产生的离散标记。

● 视觉数据:图像通过预训练的视觉编码器如SigLIP(翟等人,2023年)进行编码。输出是连续的视觉标记,然后插值到m=64个标记。为了将这些视觉标记作为输入传递给LLM,我们应用一个可训练的投影层,以与LLM的维度对齐。

模型架构。我们取一个预训练的LLM并对其进行微调,以处理任意序列的文本和视觉标记(详细内容将在第2.2节中说明)。我们保留原始的LLM头部用于文本预测,并为LLM附加一个独立的视觉头部用于预测视觉标记,即视觉编码器在处理图像时生成的输出标记。视觉头部是一个从LLM的维度投影到视觉编码器的维度的投影层。所有响应标记随后可以自回归地训练和预测,以提示标记作为上下文。

与传统的视觉指令微调不同,在VPiT中,视觉标记也是LLM的输出——不仅仅是输入。为了让大型语言模型(LLM)意识到视觉标记的存在,我们引入了特殊标记和〈image_end〉来指示视觉标记序列的边界以及何时使用视觉头部。

损失函数。语言头部输出一个词汇表上的概率分布,并使用交叉熵损失进行下一个标记的预测训练。视觉预测使用LLM预测的视觉标记与视觉编码器产生的标记之间的余弦相似度损失。与指令调整实践一致,模型仅在响应标记上进行预测并产生损失。

2.2 使用多种类型的数据

因为VPiT使其能够在响应中同时预测文本和视觉标记,它允许使用更广泛的训练数据。另一方面,传统的视觉指令调整主要依赖于问答对。我们的数据集大部分是公开可用的,我们在下面将其分为三个主要类别。这种分类使我们能够系统地研究模型,如第3节和第4节详细说明。所有数据类型都按照指令调整风格的提示&响应对格式。更多细节请参见附录C.2。

- 视觉理解数据:这一类别包括以图像或视频作为输入并输出文本响应的数据。请参见图1以获得示例。我们使用:

- 图像问答:Cambrian-7M(汤等人,2024a)。该模型根据输入的图像回答问题。

Pi∈{⟨视觉标记⟩,⟨文本提示⟩}Ri∈{⟨ 文本响应 ⟩}

- 视频问答(VideoQA):VideoStar(佐哈尔等人,2024年)和ShareVideo(张等人,2024年)。该模型根据输入视频回答问题。对于视频问答中的视频,我们以每秒1帧的速度处理帧。

Pi∈{⟨视觉标记⟩,⋯,⟨视觉标记⟩,⟨文本提示⟩}Ri∈{⟨ 文本回应 ⟩}

- 视觉生成数据:MetaCLIP(徐等人,2024年)。该模型根据图像描述预测视觉标记。我们最多使用500万对数据。我们将数据整理成问答格式。

Pi∈{⟨ 文本提示 ⟩}Ri∈{⟨文本回应⟩,⟨视觉标记⟩}

我们通过“生成……的图像”等指令提示模型生成视觉标记。文本回应是“根据您的请求,这里是相应的图像……”。请参见图1以获取示例。

- 其他视觉数据:该类别包括需要模型根据交错输入的视觉标记和文本标记预测视觉标记的数据。我们使用:

- 视频数据:SomethingSomethingV2(戈亚尔等人,2017b)和HowTo100M(米切等人,2019年)。该模型按顺序预测帧。我们设计不同的问题-答案对来探究视频,例如询问未来帧、过去帧以及重新排序帧。Pi∈{⟨视觉标记⟩,⋯,⟨视觉标记⟩,⟨文本提示⟩} Ri∈{⟨ 视觉标记 ⟩,⋯,⟨ 视觉标记 ⟩}

● 视觉思维数据:思考可视化(Shao等人,2024年)和VStar(吴和谢,2024年)。该模型在解决问题之前会预测响应中的多模态标记。例如,在生成文本响应之前,它会预测一个图像的放大视图。

Pi∈{⟨视觉标记⟩,⟨文本提示⟩}Ri∈{⟨ 文本响应 ⟩,⟨ 视觉标记 ⟩,⟨ 文本响应 ⟩}

在响应中,模型会输出“我会用视觉思考它”,接着是代表图像放大部分的视觉标记,然后继续回答问题。

● 图像到图像数据:指导Pix2Pix(Brooks等人,2023年)和Aurora(Krojer等人,2024年)。该模型根据文本描述和输入图像生成转换后的图像。

Pi∈{⟨视觉标记⟩,⟨文本提示⟩}Ri∈{⟨ 视觉标记 ⟩}

2.3 通过扩散将标记映射到图像

因为使用VPiT训练的模型学会了预测连续的视觉标记,我们需要将这些预测的标记映射回像素空间。我们利用“扩散自编码器”(Bordes等人,2022年;Preechakul等人,2022年;Pan等人,2024b年;Koh等人,2024年;Li等人,2024c年)的概念,其中扩散模型可以适应于根据图像嵌入而不是文本嵌入进行条件化。具体来说,我们微调现有的扩散模型,使其能够使用保留的训练数据根据视觉编码器的输出来进行条件化。

在推理时,如果生成了标签标记〈image_start〉,模型开始输出视觉标记直到⟨ image_end ⟩。然后我们将生成的视觉标记插入到扩散模型中,以在像素空间可视化预测结果。我们使用标准的潜在扩散模型训练程序。有关超参数和训练设置的详细信息,请参见附录A.2。

3 关于解锁视觉生成的发现

我们在我们的VPiT框架下研究关于视觉理解与生成的效果和协同作用以下问题:

§3.1 视觉生成可以通过轻量级调整解锁吗,还是需要大量数据?

§3.2 视觉理解与生成是相互有益还是相互独立?

§3.3 更多的视觉理解或生成数据对理解和生成质量贡献多少?

§3.4 哪些视觉理解任务与生成性能的相关性最高?

评估设置。我们使用9个图像问答基准测试(MMBench、Seed、VStar、MMMP、MMMU、ChartQA、TextVQA、ScienceQA、RealWorldQA)来评估模型的不同方面。对于图像生成,我们使用微调的扩散模型来可视化生成的视觉标记,并在COCO-30K数据集上测量FID分数(越低越好)和CLIP分数(越高越好)。除非另有说明,我们使用LLaMA-38B(AI@Meta,2024)/ SigLIP ViT-SO400M-14@384(翟等人,2023年)作为预训练的LLM/视觉编码器。我们还研究了第3.2节中不同LLM的效果。我们使用指令微调的LLM版本。我们遵循视觉指令调整(Liu等人,2023年,2024a年)的方法,对视觉编码器和大型语言模型之间的适配器进行预训练。在本节的实验中,我们在附录A中提供了训练细节,并在附录B中包含了完整结果。

3.1 通过与视觉理解的联合训练可以高效解锁视觉生成

我们首先调查了教授语言模型生成高质量视觉标记所需的图像-文本样本数量。为此,我们从我们的生成数据(MetaCLIP数据集(Xu等人,2024))中随机抽取{1k,5k,10k,50k,200k,1M,3M,5M}个图像-文本对。我们探索了两种设置:(1)仅使用视觉生成数据对大型语言模型进行微调,(2)联合训练视觉生成、视觉理解以及第2.2节描述的其他数据类型。

在图2中,我们看到仅基于视觉生成数据进行训练的表现明显不如与其他所有数据进行联合训练。拥有超过3百万个图像-文本对时,模型难以生成高质量的视觉图像(约40的FID分数),且表现仍然次于与5百万对数据进行联合训练。这表明仅基于视觉生成数据进行训练显著地样本效率较低。这一发现与先前的研究(Zhang等人,2023年)一致,该研究也表明当仅用生成数据进行训练时,大型语言模型不容易被调整来生成视觉标记。相比之下,与其他数据集的联合训练显著提高了生成性能。该模型仅需5K的生成数据就能生成有效的视觉标记,并且在大约20万个样本后性能趋于稳定。这表明视觉生成并非一个正交能力,而是从其他任务中受益的一种能力,并且通过联合训练能够更有效地显现出来。

图2 仅生成训练与联合训练。仅对tr的生成数据进行训练会导致性能较差。与其他数据联合训练,使用仅5k的生成数据就能进行视觉生成,而使用200k的生成数据则能产生高质量的输出。

不同数据类型对视觉生成的影响。仅使用视觉生成数据的基线是红色的;与数据联合训练的是黄色的;与视觉理解数据联合训练的是橙色的;所有数据则是蓝色的。与额外数据联合训练提升了基线,其中对视觉生成的增强贡献最大的是视觉理解任务。

图4 在生成数据控制在20万的情况下,视觉问答(VQA)性能与生成性能的对比。增加理解数据可以提高VQA和生成性能。

图5 在VQA数据控制在1百万(1M)的情况下,生成性能与VQA性能的对比。增加生成数据可以提高生成和VQA性能。

为了更好地理解每种类型的数据如何有助于视觉生成,我们使用20万(200k)视觉生成数据进行了一项受控实验,该实验分别与第2.2节中定义的每种数据类型联合训练。我们还将其与将所有数据一起训练的结果进行了比较。我们在图3中展示了结果。虽然所有类型的数据都增强了模型的视觉生成能力,但改进的程度各不相同。例如ImageQA和视频QA之类的视觉理解数据显著提升了模型的视觉生成能力,即便在生成数据量保持在20万的恒定情况下也是如此。这表明理解视觉内容的能力与生成视觉标记之间存在强烈联系。此外,在训练中结合所有数据类型进一步提高了性能,这表明不同数据类型的好处可能是累加的。

发现1:当模型与视觉理解数据联合训练时,与仅在生成数据上进行训练相比,可以用明显较少的生成数据解锁生成视觉标记的能力。

3.2 视觉理解与生成是相互促进的

更多的理解数据带来更好的理解和生成。在前一小节的发现基础上,我们进行了一项受控实验,以探究视觉理解能力与视觉生成能力之间的相关性。我们使用一组固定的20万条生成数据来微调我们的模型,同时改变来自寒武纪-7百万样本集的1百万至7百万个视觉问答(VQA)数据样本,以发展不同水平的视觉理解能力。图4中展示的结果表明,更强的VQA能力与更好的生成表现相关联。

更多的生成数据带来更好的理解和生成效果。在这里,我们探究相反的方向:提升模型的视觉生成能力是否也与更高的VQA表现相关?为了探索这一点,我们使用1百万个固定的VQA样本作为基线进行理解的受控实验。然后我们改变生成数据的数量({20万、50万、1百万、2百万、3百万、4百万}),在联合训练固定1百万VQA数据的同时调整生成容量。我们在图5中展示了结果。在1百万VQA设置下,更强的生成能力与改进的VQA表现相关联。这意味着增加生成数据的量不仅增强了生成效果,而且对VQA表现也有积极影响。

这种协同效应在不同的大型语言模型(LLM)之间是成比例的。我们检验这些发现是否适用于各种LLM的基础架构。使用7百万个VQA样本和1百万条生成数据的数据组合,我们在LLaMA-3 8B、LLaMA-3.1 8B和LLaMA-3 70B上训练VPiT。图6展示了不同LLM之间的扩展行为。

发现2:视觉理解与生成是协同作用。增加任一能力的数据同时提升了两者。

图6 不同语言骨干之间的比较。我们在不同的语言骨干(LLaMA-3 8B、LLaMA-3.18B、LLaMA-3 70B)上联合训练了7百万个视觉问答和1百万个生成数据。我们观察到理解能力和生成能力在大型语言模型之间的协同转移。

图7 平均视觉问答(VQA)得分、生成对抗网络(FID)得分和CLIP得分的热图可视化,这些得分随着VQA数据和生成数据的数量变化而变化。颜色越深表示表现越好。增加VQA数据对于提高理解和生成能力更为有效。

3.3 理解数据贡献更大

我们调查了理解和生成数据是否贡献相同。这里,我们联合训练不同规模的VQA数据(100万、400万、700万)和生成数据(20万、50万、100万、200万、300万、400万)。图7总结了这些发现,其中x轴代表VQA数据,y轴代表生成数据。结果在热图上使用较深的颜色进行可视化,以显示更好的表现。

结果表明,增加VQA数据在所有三个指标上带来最显著的改进。当VQA数据相对较低(100万)时,增加生成数据会导致明显的改进,如图中的逐渐加深所示。然而,随着VQA数据量的增加(从100万到400万再到700万),VQA数据的影响变得更加明显,这在热图中表现为颜色的急剧转变。最终,在拥有700万VQA数据的情况下,增加生成数据的贡献最小。这些结果展示了理解数据在提升理解和生成性能中的关键作用。

发现3:虽然增加数据总体上提高了性能,但视觉理解数据的影响显著高于视觉生成数据的影响。

3.4 特定理解任务与生成性能的相关性更高

鉴于理解任务如OCR、以视觉为中心的任务和基于知识的任务具有多样化的特点,我们调查了哪些任务与生成能力的相关性最强。受到寒武纪-1的启发,我们将视觉问答(VQA)任务分为五类:一般、文本与图表、高分辨率、知识和以视觉为中心的VQA。利用我们早期实验的结果,这些实验联合训练了各种VQA数据规模,并使用了不同数量的生成数据,我们在图8中将每个基准的VQA性能与生成性能进行了对比。我们还计算了VQA分数与FID/CLIP分数之间的皮尔逊相关系数(p)。

图8 生成与各种理解基准之间的相关性分析。结果是通过结合不同量的生成数据,对不同数量的视觉问答(VQA)数据进行联合训练而收集的。每个子图显示了与拟合回归线的相关性(p)。星号代表数据点。我们分析了通用VQA、以视觉为中心的VQA、文本与图表VQA、高分辨率VQA以及知识型VQA。对于大多数任务,生成性能与VQA性能强烈相关:VQA性能越高,表示生成效果越好,反之亦然。只有知识密集型和高度分辨率的VQA任务与生成性能的相关性较弱。

图8显示,通用、以视觉为中心和文本与图表VQA任务与生成性能强烈相关,每个的皮尔逊相关系数(p)均超过0.85。高分辨率VQA表现出中等相关性,p值约为0.7。相比之下,知识型VQA任务,如MMMU,与生成性能的相关性较弱。这些发现表明,生成能力与模型的视觉能力更为紧密地对齐,而不是特定于知识的任务。

发现4:通用、以视觉为中心和文本理解的VQA任务与视觉生成表现出强相关性,而基于知识的VQA任务则没有。

4 MetaMorph模型

根据第3节的见解,我们基于LLaMA-3.1 8B(AI@Meta,2024)训练我们的统一模型MetaMorph,使用第2.2节中策划的数据进行VPiT训练。我们将实验结果分为三个部分呈现:定量性能(第4节)。1) 在视觉生成中利用大型语言模型(LLM)知识的元形态(MetaMorph)的证据(第4.2节),以及在多模态环境中进行隐性推理的能力(第4.3节)。

| Image QA | Image QA | Image QA | Image QA | Image QA | Image QA | Image QA | Image QA | Image QA | Video QA | Generation | ||

| Method | Base LLM | MMBenchEN | aS | RealworldQA | dMw | SQA | MMMU | VStar | ChartQA | TextVQA | W-Bench | d) |

| Visual Understanding Only | ||||||||||||

| GPT-4V* | 75.8 | 69.1 | 61.4 | 50.0 | 75.7 | 56.8 | 55.0 | 78.5 | 78.0 | 43.5 | ||

| Visual Generation Only | ||||||||||||

| Stable Diffusion 1.5* | – | – | – | – | – | – | – | 9.6 | ||||

| Dalle 2* | – | – | – | – | – | – | 10.4 | |||||

| Imagen | – | – | – | – | – | – | – | – | – | – | 7.3 | |

| Unified Models | ||||||||||||

| EMU-3* | 58.5 | 68.2 | 57.4 | 36.6↑ | 89.2 | 31.6 | 51.8 | 68.6 | 64.7 | – | 12.8 | |

| Janus* | DeepSeek 1.3B | 69.4 | 63.7 | 30.5 | – | 8.5 | ||||||

| VILA-U256 | LLaMA-2 7B | 66.6 | 57.1 | 46.6 | 22.0 | 67.1 | 32.2 | 38.7 | 11.4 | 48.3* | 40.8 | 19.6 |

| Transfusion* | – | 6.7 | ||||||||||

| Chameleon-7B | 35.7 | 27.2 | 19.6 | 0.0 | 50.3 | 28.4 | 37.1 | 0 0.0 | 0.0 | – | 26.7* | |

| MetaMorph(ours) | LLaMA-3.1 8B | 75.2 | 71.8 | 58.3 | 48.3 | 83.2 | 41.8 | 44.0 | 37.1 | 60.5 | 48.8 | 11.8 |

表1 MetaMorph与其他统一模型的比较。与其他领先统一模型相比,MetaMorph表现出具有竞争力的性能。灰色模型仅进行理解或仅进行生成。没有基础大型语言模型的统一模型是从头开始训练的。*我们使用原始论文中报告的数字。† 我们使用官方开源的模型权重获得结果。

4.1 在理解和生成方面的竞争力表现

我们将MetaMorph与其他统一模型进行比较,并在表1中总结结果。由于这些模型在不同的数据集和基础大型语言模型(或从头开始预训练)上进行训练,很难进行直接比较。尽管如此,MetaMorph在大多数基准测试上仍然展现出竞争力,甚至超过了之前可能在更多数据上训练的模型。与从头开始训练的模型相比,如EMU-3(Wang等人,2024b)和变色龙(团队,2024年),MetaMorph利用了最新预训练大型语言模型的优势,实现了具有竞争力的理解和生成性能。MetaMorph强调,可以从预训练的大型语言模型中有效地开发出统一模型。

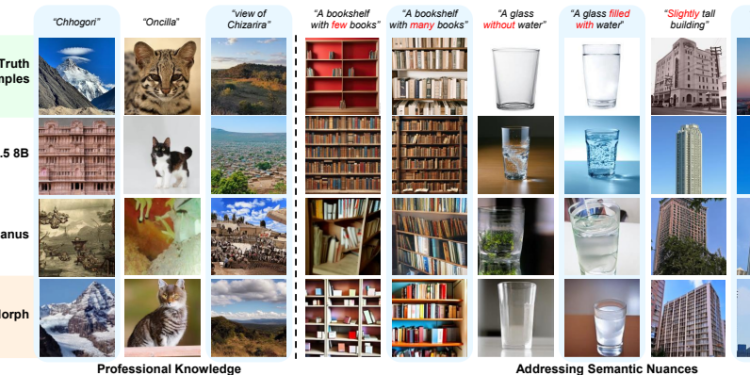

图9 MetaMorph利用大型语言模型(LLM)生成视觉标记的示例。左图:MetaMorph可以利用来自LLM的知识,为需要特定领域理解的专业术语生成视觉标记。右图:MetaMorph还避免了在基于文本嵌入的条件转换至图像(T2I)模型中常见的错误(例如,Stable Diffusion-3.5 8B)。

4.2 MetaMorph可以利用LLM知识进行视觉生成

MetaMorph有效地利用了预训练LLM中嵌入的世界知识。我们在图9左侧展示了示例。我们提示模型生成需要非平凡和专门知识的概念。示例包括“乔戈里”(世界第二高峰)、“奥西拉”(一种来自南美洲的小型野猫)以及“奇扎里拉”(津巴布韦的一处孤立的荒野区)。

MetaMorph成功地将特定领域的知识转换为准确的视觉标记,从而展现了其利用LLM中的世界知识的能力。相比之下,最新的文本到图像(T2I)模型Stable Diffusion-3.5 8B,尽管能够生成高质量的图像,但在生成正确概念方面却存在困难。这个问题可能源于它所使用的文本嵌入模型——CLIP(Radford等人,2021年)和T5(Roberts等人,2019年)——这些模型未能适当地编码这些专业术语(Yuksekopnul等人,2022年)。

在图9右侧,我们展示了MetaMorph如何比CLIP和T5等文本嵌入模型更有效地处理常见的语义挑战。这些挑战包括否定和主观性,使用在Multimon(汤等人,2024b年)中识别出的常见失败模式的提示。MetaMorph区分语义细微差别,如“略微”与“非常”、“少数”与“许多”、“没有”与“有”,这些是现有文本到图像系统中的常见失败。

4.3 多模态生成中的推理

在图10中,我们展示了模型响应谜题提示生成图像的例子,例如“黄石国家公园所在国家的国旗”。对于每个谜题,我们直接使用提示“生成{谜题}的图像”,而不在提示中调用任何思维链(CoT)(魏等人,2022b年)。MetaMorph能够从需要多步推理的提示中生成正确的图像。

例如,在回答“一种乐器,这个乐器通常由提出特殊相对论理论的科学家演奏”的问题时,模型需要隐含地完成三个推理步骤:它识别出提出特殊相对论理论的科学家是阿尔伯特·爱因斯坦,认识到他偏好的乐器是小提琴,然后直接生成正确的视觉标记——一把小提琴——而无需在生成过程中显式地分隔这些步骤。这一结果意味着MetaMorph隐含地解决了谜题,并在提示之后立即生成了正确的视觉标记。这些结果与大型语言模型物理学方面的发现一致(叶等人)。(张等人,2024年;艾伦-朱等人,2024年),在这些研究中,作者建议大型语言模型在自回归生成后续标记之前预计算推理图。在这里,我们展示了即使在对视觉标记进行解码时,这种能力也能转移到统一的多模态模型设置中。

图10 示例:MetaMorph在视觉生成中解决推理问题。我们设计了需要多步推理的谜题。我们包含了解决谜题所需的参考逻辑链和参考解决方案示例。在提示每个模型时,我们直接输入谜题,而不提供任何CoT提示或逻辑链。MetaMorph能够隐式地解决这些谜题并生成正确的图像,而无需显式创建或处理逻辑链。这表明仅在文本的LLM中的隐式推理技能可以转移到统一的多模态模型中。

5 相关工作

指令调整和视觉指令调整。指令调整(Wei等人,2022a;Taori等人,2023年)微调预训练的LLM以学习交互的格式和风格。这个过程帮助模型有效地传达在预训练期间获得的知识与能力(Zhou等人,2024a)。LLaVA(Liu等人,2023年)将指令调整扩展到多模态领域。从那时起,不同研究方向关注于改进数据策展(Chen等人,2023年;Laurencon等人,2024a,b)、视觉表征(Tong等人,2024a;Kar等人,2025年;Chen等人,2024b)以及指令调整策略(Gao等人,2024年;Liu等人,2024b)。仅使用几百万条多模态指令调整数据,这一研究方向(Liu等人,2024b;Tong等人,2024a;Li等人,2024a)已经使开源的多模态LLM在多个基准测试上的性能达到与专有模型(OpenAI,2024年;Anthropic,2024年)相当的水平(Liu等人,2024d;Yue等人。多模态大型语言模型到统一模型的转换。构建统一模型的最新努力主要依赖于广泛的预训练或在十亿级数据集上的密集微调。一些研究还使用连续嵌入来预测视觉标记,整合视觉回归损失(孙等人,2024b,a)或利用基于扩散的方法(董等人,2024)。其他方法(陆等人,2022a;阿加贾尼扬等人,2022;团队,2024;吴等人,2024b;刘等人,2024c;王等人,2024b;陆等人,2024)将多模态数据分词为离散标记,然后使用自回归变压器进行训练。最近的研究还探索了结合自回归和扩散目标的混合策略(周等人,2024b;谢等人,2024)。与以往的研究不同,我们展示了在低数据量情况下,统一模型可以在指令微调期间有效训练,同时也提供了对视觉理解与视觉生成之间相互关系的洞察。

6 讨论

在这项工作中,我们提出了一种简单而有效的视觉指令微调扩展——VPiT,它使大型语言模型能够预测多模态标记。VPiT解锁了比仅视觉问答更广泛范围的指令微调数据的使用,例如文本到图像以及纯图像和视频数据。通过控制实验,我们发现视觉生成能力作为改进的视觉理解的天然副产品出现,并且需要适度的额外生成数据。此外,我们发现虽然视觉理解和生成是相互促进的,但相比增加更多的生成数据,增加更多的视觉理解数据能不成比例地提高整体性能。

利用这些见解,我们通过用VPiT微调LLaMA-3.1 8B来训练MetaMorph。通过一个简单的训练过程,MetaMorph在视觉理解和生成方面都取得了有竞争力的表现。我们模型的定性评估显示,MetaMorph能够在视觉生成过程中利用基础大型语言模型的世界知识和推理能力。例如,它可以执行通常需要多步推理的多模态任务,如生成专业专有名词(“Chhogori”)的图像或解决视觉谜题(“生成蝴蝶变态后动物的图像”)。这表明大型语言模型已经拥有了一定程度的“先验”视觉知识,只需通过VPiT进行最小限度的指令调整就能激活。总体而言,大型语言模型可能具有与统一且多功能模型相似的表示空间(Huh等人,2024年)。我们希望这项工作的见解能够激发更多探索,朝着开发用于通用智能的大型语言模型发展。

7. 关键问题及回答

问题1:VPiT方法如何在模型架构上实现文本和视觉令牌的联合预测?

VPiT方法在模型架构上通过添加一个视觉头来实现文本和视觉令牌的联合预测。具体来说,模型采用预训练的LLM,并在其基础上附加一个视觉头,用于预测视觉令牌。LLM的原始文本头保持不变,用于文本预测。所有响应令牌可以自回归地训练和预测,以提示令牌为上下文。视觉令牌可以通过一个适应的扩散模型进行可视化。这种架构使得模型能够同时处理文本和视觉输入,并输出相应的令牌。

问题2:VPiT方法在数据类型上有哪些扩展,这些数据类型如何帮助模型提升视觉生成能力?

VPiT方法在数据类型上进行了扩展,包括视觉理解数据、视觉生成数据和其他视觉数据。具体数据类型包括图像问答(如Cambrian-7M)、视频问答(如VideoStar和ShareVideo)、元CLIP、视频数据(如SomethingSomethingV2和HowTo100M)、视觉思维数据(如Visualization-of-Thought和VStar)、图像到图像数据(如InstructPix2Pix和Aurora)等。这些数据类型的多样性使得模型能够学习到不同类型的视觉和文本信息,从而提升其视觉生成能力。特别是视觉理解数据(如ImageQA和VideoQA)对生成能力的提升最为显著。通过联合训练,模型可以在较少的视觉生成数据下解锁视觉生成能力。

问题3:实验结果表明,VPiT方法在理解和生成任务上的表现如何?与其他方法相比有何优势?

实验结果表明,VPiT方法在视觉理解和生成任务上取得了竞争性的性能。具体来说,通过联合训练,模型可以在较少的视觉生成数据下解锁视觉生成能力,显著提高了生成性能。同时,增加理解数据可以提高生成和理解性能,反之亦然。理解数据的增加对生成和理解性能的提升更为显著。与其他需要大量数据和复杂架构的方法相比,VPiT方法在低数据量下实现了高效的视觉理解和生成,展示了LLM在低数据量下的强大潜力。这些发现为混合模态模型的发展提供了新的见解,并可能激发更多关于LLM通用智能开发的探索。

![Slow Perception: Let’s Perceive Geometric Figures Step-by-step[缓慢感知:让我们逐步感知几何图形]-AI论文](https://assh83.com/wp-content/uploads/2025/01/1-1-360x180.png)

![Large Concept Models:Language Modeling in a Sentence Representation Space[大型概念模型:在句子表示空间中的语言建模]-AI论文](https://assh83.com/wp-content/uploads/2025/01/image-1-360x180.png)

![Cultural Evolution of Cooperation among LLM Agents[大型语言模型代理间合作的文化演化]-AI论文](https://assh83.com/wp-content/uploads/2025/01/image-360x180.png)

![Cultural Evolution of Cooperation among LLM Agents[大型语言模型代理间合作的文化演化]-AI论文](https://assh83.com/wp-content/uploads/2025/01/image-75x75.png)

![Do NOT Think That Much for 2+3=? On the Overthinking of o1-Like LLMs[不要过度思考2+3等于几 在类LLM的过度思考上]-AI论文](https://assh83.com/wp-content/uploads/2025/01/1-2-350x250.png)

![Slow Perception: Let’s Perceive Geometric Figures Step-by-step[缓慢感知:让我们逐步感知几何图形]-AI论文](https://assh83.com/wp-content/uploads/2025/01/1-1-350x250.png)

![Ensembling Large Language Models with Process Reward-Guided Tree Search for Better Complex Reasoning[结合大型语言模型与过程奖励引导的树搜索以提升复杂推理能力]-AI论文](https://assh83.com/wp-content/uploads/2025/01/1-350x248.png)

![Large Concept Models:Language Modeling in a Sentence Representation Space[大型概念模型:在句子表示空间中的语言建模]-AI论文](https://assh83.com/wp-content/uploads/2025/01/image-1-350x250.png)