1. Introduction(介绍)

本章介绍了论文的背景、挑战和提出的解决方案。主要内容如下:

随着人工智能的快速发展,大型语言模型(LLMs)如GPT-4和LLaMA等已经在自然语言处理(NLP)任务中取得了显著进展。这些模型通过数十亿个参数进行训练,展现出了卓越的语言理解和生成能力。尤其是这些模型的推理能力和上下文学习能力,使其在解决复杂问题方面具有巨大潜力,包括数学问题和战略性任务等。

然而,尽管LLMs在多个领域表现优异,但在复杂的数学推理中仍面临显著挑战。尤其是在需要准确性和逻辑推理的场景中,LLMs的输出往往缺乏足够的可靠性和精确性。一个常见的问题是“幻觉现象”,即模型生成的输出在表面上看似合理,但实际却不正确或不相关。这对需要精确答案的数学问题尤为不利,可能导致错误结论的传播。

为了解决这些问题,论文提出了一种创新算法,称为MCT Self-Refine(MCTSr),该算法结合了大型语言模型与蒙特卡洛树搜索(Monte Carlo Tree Search, MCTS)。MCTS是一种在游戏和复杂决策问题中广泛应用的决策工具,通过系统化的探索来构建搜索树,模拟可能的结果,优化决策过程。

本文的主要贡献:

- 提出了MCTSr算法,将蒙特卡洛树搜索与LLMs相结合,以提高模型在复杂数学推理任务中的表现,特别是在奥林匹克级别的数学问题上取得显著进展。

- 改进了MCTS算法的关键组件,使其更好地适应LLMs的生成特性,包括设计了一种动态剪枝策略,并优化了上置信界(UCB)公式,平衡了探索与利用的关系。

- 通过广泛的实验,验证了MCTSr算法的有效性,在多个数据集(如GSM8K、MATH、AIME等)中表现出优异的解决问题能力。

这项研究不仅推进了LLMs在复杂推理任务中的应用,还为未来AI技术在决策准确性和推理可靠性方面的进一步集成奠定了基础。研究的代码已公开,可以在GitHub上访问。

关键词:大型语言模型(LLM),蒙特卡洛树搜索(MCTS),数学推理,算法优化,决策平衡。

2. Preliminary(预备知识)

本章节介绍了论文中涉及的基本概念和符号,特别是关于蒙特卡洛树搜索(Monte Carlo Tree Search, MCTS)的相关内容。为了更好地理解后续提出的MCT Self-Refine(MCTSr)算法,需要首先掌握这些基础知识。

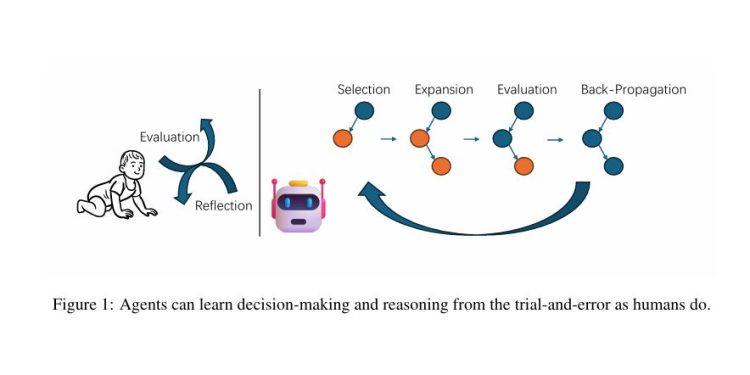

2.1 Monte Carlo Tree Search(MCTS)的机制

**蒙特卡洛树搜索(MCTS)**是一种在游戏和复杂决策过程中广泛应用的算法。它通过构建搜索树并模拟不同动作的结果,估计每个动作的价值。MCTS算法通常分为四个阶段进行:

- Selection(选择)

算法从根节点出发,根据某种策略(例如上置信界 UCT)选择最有潜力的子节点,直到到达叶子节点。

- Expansion(扩展)

到达叶子节点后,除非该节点已经是终止状态,否则会为该节点添加一个或多个新的子节点,表示未来可能的动作。

- Simulation(模拟)

从新增的子节点出发,算法进行随机模拟(通常称为“rollouts”),直到问题解决或达到某种终止状态,以评估节点的潜在价值。

- Backpropagation(回传)

模拟结束后,模拟结果(例如胜利、失败或平局)被回传到根节点,更新该路径上每个节点的统计数据(如胜率),以改进未来的决策。

通过重复上述步骤,MCTS不断构建和优化决策树,在无法直接计算最优策略的情况下,逐步接近最优决策。

2.2 Upper Confidence Bound (UCB) Formula

MCTS中的选择阶段通常依赖于**上置信界(Upper Confidence Bound, UCB)**算法,用来平衡探索与利用。UCB策略通过选择那些在模拟中表现较好、但仍有潜力的动作。具体来说,UCB公式如下:

- (\bar{X}_j) 是动作 (j) 的平均奖励。

- (N_C) 是当前节点被访问的总次数。

- (N_j) 是节点 (j) 被访问的次数。

- (C) 是控制探索与利用平衡的常数。

通过这个公式,算法能够在探索新路径和利用现有信息之间找到最佳的平衡。

2.3 MCT Self-Refine (MCTSr) 算法

论文提出的MCT Self-Refine(MCTSr)算法,将MCTS与大型语言模型(LLM)结合,将数学问题解答的优化过程抽象为搜索树结构。树上的每个节点代表不同版本的答案,而边则表示对答案进行改进的尝试。该算法遵循MCTS的基本模式,但加入了LLM特有的自我反思与自我评估机制。

MCTSr算法的符号定义如下:

- P:问题实例。

- A:节点集,表示问题的潜在答案。

- M:每个节点上的动作集,表示对答案的可能改进。

- R:基于修改质量对节点进行自我奖励的函数。

- Ra:存储节点 (a) 的所有奖励样本的集合。

- T:确定搜索过程终止的函数(如达到最大迭代次数或解答质量足够高)。

- Q(a):估计节点 (a) 的价值函数,基于奖励样本和子节点的回传结果计算。

- U(a):节点 (a) 的上置信界,用于在探索和利用之间取得平衡。

3. Methodology(方法论)

本章节详细介绍了MCT Self-Refine(MCTSr)算法的工作流程和具体实现步骤。MCTSr结合了蒙特卡洛树搜索(MCTS)与大型语言模型(LLM),通过自我反思与自我评估机制,逐步优化解答质量。以下是MCTSr算法的主要组成部分和工作机制。

3.1 MCTSr 的总体结构

MCTSr算法的工作流程如下:

- 初始化(Initialization)

创建根节点,根节点可以通过模型生成的初始答案,也可以使用一个简单的默认应答(如“我不知道”),以避免模型过拟合到某个特定的初始解答。

- 选择(Selection)

使用一个价值函数 (Q(a)) 对所有未完全扩展的答案进行排名,并选择最高分的节点进行进一步探索和优化。算法采用贪婪策略选取最优节点。

- 自我优化(Self-Refine)

选中的答案 (a) 将通过自我优化框架进行改进。首先,模型生成反馈 (m),引导优化过程,生成改进后的答案 (a’)。

- 自我评估(Self-Evaluation)

改进后的答案会被模型打分,以采样奖励值并计算其 (Q(a)) 值。这涉及模型的自我反馈机制,并通过严格的评分标准确保可靠性和公平性。

- 回传(Backpropagation)

改进后的答案的价值会回传到其父节点及相关节点,更新树中的价值信息。如果子节点的 (Q) 值发生变化,父节点的 (Q) 也会相应更新。

- UCT更新(UCT Update)

在所有节点的 (Q) 值更新完成后,算法通过UCT公式更新节点的值,以便在下一个选择阶段继续探索。

上述流程持续迭代,直到满足终止条件(如达到最大迭代次数或达到足够好的解答质量),最终得到最优答案。

3.2 Self-Refine(自我优化)

自我优化是MCTSr算法的核心步骤之一。该过程通过多轮对话引导模型逐步优化答案。具体步骤如下:

- 模型首先生成关于答案 (a) 的反馈 (m),批判性地指出当前答案中的不足之处。

- 然后,模型根据反馈 (m) 对答案 (a) 进行修改,生成改进后的答案 (a’)。

- 这一优化过程是迭代的,模型每次根据反馈逐步改进答案的质量。

3.3 Self-Evaluation(自我评估)

在自我优化的过程中,模型需要对改进后的答案进行评估,计算其 (Q(a)) 值。这一评估过程涉及以下几个方面:

- 自我奖励方法(Self-Reward Method)

模型使用一个评分系统,对每个解答 (a) 的质量进行打分,分数范围为 -100 到 100。模型需要严格按照评分标准进行评估,避免给出过高的分数。

- 评分约束(Scoring Constraints)

为了确保评分的客观性,设计了以下约束条件:

最终,模型根据采样的奖励值计算出 (Q(a)) 值。为防止过度平滑的评分趋势,公式中引入了一个最小值约束,确保评分的准确性。

3.4 Backpropagation(回传)

在所有叶节点的奖励值和 (Q) 值更新完成后,算法会将这些变化回传到父节点和祖先节点。具体来说,如果某个节点 (a) 的子节点集合 Children(a) 中的任何一个节点的 (Q) 值发生变化,则父节点 (a) 的 (Q) 值也会更新。

更新后的 (Q'(a)) 值通过以下公式计算:

这个公式通过将节点的当前 (Q) 值与其子节点的最大 (Q) 值相结合,优化父节点的评估值。

3.5 Update UCT and Selection(UCT更新与选择)

在完成所有节点的 (Q) 值更新后,算法会进入下一轮选择阶段,选择新的节点进行探索。选择过程包括以下步骤:

- 候选节点选择

基于数学问题的马尔可夫性质,算法会选择所有叶节点或未完全扩展的节点作为候选节点进行进一步扩展。通过对这些节点进行层次遍历,确定最优节点。

- UCT更新

为了平衡探索与利用,算法采用了AlphaGo中使用的UCT公式进行节点更新。具体公式为:

其中,(Q(a)) 是节点的 (Q) 值,(N(\cdot)) 是节点被访问的总次数,(c) 是平衡探索与利用的常数,(\epsilon) 是防止除零的小常数。

- 排序与选择

根据候选节点的UCT值,算法通过贪婪采样或重要性采样选择最优节点进行进一步的优化。

3.6 Termination Function(终止函数)

MCTSr算法的终止条件可以通过以下几种方式实现:

- 早停策略(Early Stopping)

:当搜索结果不再有显著改进,或者连续的搜索结果重复时,算法会提前终止。

- 搜索约束(Search Constraints)

:当迭代次数达到预设的限制,或者树中某些节点满足最大深度约束时,搜索会终止。

- 基于语言模型logits的高级标准(Advanced Criteria Based on Language Model Logits)

:根据模型的logits(输出概率分布)定义的高级标准,决定是否结束搜索。

一旦满足终止条件,算法会根据 (Q) 值或其他标准从树节点中选出最佳答案。

4. Evaluation(评估)

本章节评估了MCT Self-Refine(MCTSr)算法在多个数学推理基准测试中的表现。主要分析了算法在不同数据集和配置下的表现差异,重点比较了MCTSr算法与其他主流语言模型(如GPT-4、Claude 3等)的性能。实验结果表明,MCTSr在解决复杂数学问题上表现优异,特别是在奥林匹克级别的数学竞赛问题中有显著提升。

4.1 Experiment Settings(实验设置)

实验使用了LLaMA3-8B模型作为基础模型,并结合了MCTSr算法来提升其数学推理能力。实验中使用了以下几种配置:

- Zero-Shot Chain of Thought (CoT):无提示推理,即不经过任何优化,直接进行问题求解。

- One-turn Self-Refine:一次自我优化,即模型根据生成的反馈进行一次解答优化。

- 4-rollouts MCTSr:执行四次MCTSr循环,优化答案。

- 8-rollouts MCTSr:执行八次MCTSr循环,进一步优化答案。

实验中使用的主要数据集包括:

- GSM8K:包含常见的数学问题。

- GSM Hard:包含较为复杂的数学问题。

- MATH:按难度等级分类的数学推理数据集。

- AIME、Math Odyssey、OlympiadBench:这些是奥林匹克数学竞赛相关的数据集,用于测试模型在高级推理问题上的表现。

4.2 GSM Benchmarks

在GSM8K和GSM Hard数据集上的评估结果显示了不同配置的MCTSr算法在数学问题上的表现:

- GSM8K

随着MCTSr的迭代次数增加,解答成功率显著提升。从Zero-Shot CoT的74.07%上升到8-rollouts MCTSr的96.66%。这表明MCTSr算法在较简单的数学问题上通过多次优化可以极大提高解答的准确性。

- GSM Hard

对于更复杂的问题,MCTSr同样显示了有效的改进。从Zero-Shot CoT的25.47%提高到8-rollouts MCTSr的45.49%。虽然进步明显,但结果也表明在高度复杂的数学问题上仍存在一定的性能上限,需要进一步优化。

4.3 MATH Benchmark

MATH数据集按照问题难度分为五个等级,MCTSr算法在不同难度等级上的表现差异显著。以下是主要结果:

- Level 1(最简单)

8-rollouts MCTSr达到了90.16%的成功率(394/437个问题),显示了显著的性能提升。

- Level 5(最难)

8-rollouts MCTSr在最难问题上的成功率为34.06%(451/1324个问题),说明随着问题难度增加,算法的性能受到了一定的限制。

总体来看,8-rollouts MCTSr在所有难度等级上达到了58.24%的成功率,相比于Zero-Shot CoT的24.36%有显著提升。这表明MCTSr算法在复杂数学推理任务中的表现优越,且随着迭代次数的增加,性能逐步提升。

4.4 Olympiad-level Benchmarks(奥林匹克级别基准测试)

MCTSr算法还在三大奥林匹克数学竞赛数据集上进行了测试:AIME、GAIC Math Odyssey和OlympiadBench。这些数据集包含了高难度的数学竞赛问题,测试模型的推理能力。

- AIME

从Zero-Shot CoT的2.36%(22个问题)上升到8-rollouts MCTSr的11.79%(110个问题),显示了该算法在极难问题上的显著提升。

- GAIC Math Odyssey

这一数据集在模型的预训练语料库中重叠较少,测试了MCTSr算法的泛化能力。成功率从Zero-Shot CoT的17.22%上升到8-rollouts MCTSr的49.36%。

- OlympiadBench

成功率从Zero-Shot CoT的1.25%提升到8-rollouts MCTSr的7.76%。

这些结果表明,随着MCTSr的迭代次数增加,成功率逐步提高,特别是在GAIC Math Odyssey数据集中,显示了算法在面对全新问题时的泛化能力。

4.5 Discussion(讨论)

实验结果表明,MCTSr算法显著提升了小参数开源模型(如LLaMA-3)的数学推理能力,使其在某些数学基准测试中接近最新的封闭源码模型(如GPT-4、Claude 3等)的性能。

虽然MCTSr在许多数据集上取得了显著提升,但复杂问题(如GSM Hard和奥林匹克级别的问题)表明算法在极高难度问题上仍存在一定的性能瓶颈,这提示未来需要进一步优化算法的各个组件,以应对更加复杂的推理挑战。

5. Related Works(相关工作)

本章节概述了与本文研究相关的几项重要工作,涵盖了**蒙特卡洛树搜索(MCTS)和大型语言模型(LLM)**在不同领域的应用与发展。通过对这些相关工作的讨论,文章展示了MCTSr算法的创新点和其在现有方法基础上的改进。

5.1 Monte Carlo Tree Search (MCTS)的应用

蒙特卡洛树搜索(MCTS)是一种用于解决复杂问题的决策算法,广泛应用于多种领域:

- 多智能体路径规划

Pitanov等人(2023)在多智能体路径规划问题中应用MCTS,证明了该算法在解决此类问题时的优越性,超过了常见的启发式搜索算法如A*。

- 列车时刻表问题(TTP)

Yang(2023)将MCTS与启发式、无监督和监督学习方法结合,用于解决列车时刻表问题,展示了MCTS在调度类问题中的有效性。

- SAT问题求解

Li等人(2023)提出了一种通用方法,通过将MCTS与SAT(可满足性)问题结合,应用于多种类型的SAT问题,展示了该算法的灵活性和强大解决能力。

- 机器人任务规划

Vagadia等人(2024)开发了PhyPlan,一个结合了物理信息神经网络与改进版MCTS的规划框架,帮助机器人有效执行动态物理任务。

通过这些研究,MCTS显示出其在多种复杂问题中的广泛适用性。研究人员还在不断探索如何将MCTS与其他算法和框架结合,以应对更具挑战性的任务。

5.2 数学推理在大型语言模型中的进展

近年来,在**大型语言模型(LLMs)**的数学推理领域也取得了显著进展:

- 多模型讨论与优化

Du等人(2023)提出了一种多语言模型协同讨论并优化答案的方法,显著提高了推理和事实准确性。

- WizardMath

Luo等人(2023)开发了WizardMath,利用强化学习和反馈进行优化,在数学基准测试中表现超过现有的语言模型。

- MathVista

Lu等人(2023)创建了一个视觉数学基准MathVista,GPT-4V在此基准中的表现为49.9%的准确率,揭示了LLM在视觉化数学问题上仍有改进空间。

- MetaMath

Yu等人(2023)提出了MetaMath,一个通过微调提升模型在数学挑战中表现的模型,展现了模型在特定任务上的改进潜力。

- 预训练损失与拒绝采样微调

Yuan等人(2023)展示了如何通过控制预训练损失与采用拒绝采样的微调方法,优化较小规模模型的数学推理性能。

这些研究说明了LLM在数学推理方面的快速发展,但同时也指出在应对复杂问题时仍存在逻辑或数值错误。这些挑战为进一步提升LLM在数学推理中的应用提出了新的研究方向。

5.3 MCTS与大型语言模型结合的研究

近期的一些研究尝试将MCTS与LLMs相结合,提升其数学推理能力:

- 无监督的MCTS增强方法

Chen等人(2024)提出了一种结合MCTS的数学推理增强方法,通过轻量级的能量函数对决策步骤进行排名,提升了模型的即时反应和推理能力。

- 能量函数引导的推理

Xu(2023)利用MCTS结合能量函数提升模型在数学推理基准测试中的表现,证明了通过引导推理路径,可以显著改善推理的准确性。

尽管这些方法有助于提升LLM的数学推理能力,但仍缺乏一种将自我优化和自我奖励评估结合MCTS的完整框架,以迭代地优化模型输出。因此,本文提出的MCTSr算法通过将MCTS与LLM的自我优化能力结合,提供了一种全新的框架来逐步改进解答质量。

6. Limitations(局限性)

本章节讨论了MCT Self-Refine(MCTSr)算法的当前局限性,以及未来可能的改进方向。尽管MCTSr算法在解决复杂数学问题中展示了显著的进步,但仍有一些局限性需要进一步研究和解决。

6.1 应用场景的局限性

MCTSr算法作为一种通用的决策框架,在数学问题解决中展现了强大的能力,但其潜在的应用范围尚未被完全探索。例如,虽然MCTSr算法在数学推理任务中表现出色,但在其他复杂任务中(如黑盒优化问题和大型语言模型的自驱动对齐任务)尚未得到充分验证。这类问题涉及高度不确定性和更广泛的搜索空间,MCTSr能否在这些情境下有效应用仍然需要进一步研究。

6.2 算法组件的可扩展性

MCTSr算法的各个组件具有高度的可扩展性,但需要进一步发展和优化。例如,算法中的自我优化和自我奖励模块在不同任务中的表现可能不同,因此需要在更广泛的问题设置中进行实验,比较各种算法组件的实际效果。这包括探索如何根据任务类型调整优化和回传策略,以提升算法的实用性和性能。

6.3 计算复杂性

虽然MCTSr通过动态剪枝和自我评估机制减少了部分计算复杂性,但其多轮迭代过程仍然可能带来较高的计算成本,特别是在面对规模庞大、状态空间复杂的任务时。未来的工作可以通过进一步优化探索-利用的平衡策略,来降低计算资源的消耗,同时保持算法的高效性。

6.4 任务的适应性

尽管MCTSr在处理数学推理问题方面展现了卓越的能力,但面对其他类型的问题(例如,非结构化的自然语言处理任务或多模态推理任务),其适应性仍有待验证。由于这些任务的特性与数学推理有较大差异,MCTSr中的某些模块(例如自我评估和优化机制)可能需要针对特定任务进行调整和适配。

6.5 结果质量与迭代次数的关系

实验结果显示,随着MCTSr的迭代次数增加,解答的准确性逐步提升。然而,在某些复杂问题上,性能的提升会出现“天花板效应”,即即使增加迭代次数,问题解决的成功率也趋于稳定,难以进一步提高。这表明当前的自我优化和评估策略可能在面对某些特定类型的复杂问题时,无法充分捕捉其内在逻辑结构。未来的研究可以探索更具创新性的优化策略,以突破当前的性能瓶颈.

7. Conclusion(结论)

在本章节中,作者总结了MCT Self-Refine(MCTSr)算法的主要贡献,并讨论了其在解决复杂数学问题中的潜力和未来应用前景。

7.1 研究成果总结

本论文提出了一种创新性算法MCT Self-Refine(MCTSr),通过将**蒙特卡洛树搜索(MCTS)与大型语言模型(LLM)**结合,解决了LLM在复杂数学推理任务中面临的准确性和可靠性问题。本文的实验结果表明,MCTSr算法显著提高了LLM在多个数据集上的问题解决能力,尤其是在奥林匹克级别的数学问题中,表现出了更高的成功率和推理质量。

通过以下几点贡献,MCTSr算法为LLM的推理任务提供了重要的改进:

- MCTS与LLM的深度集成:通过系统化的探索和自我优化机制,提升LLM在数学推理中的表现。

- 动态剪枝与改进的上置信界公式:引入了动态剪枝模块,结合改进的UCB公式,优化了探索与利用的平衡。

- 实验验证:通过在多个数学基准数据集上的实验,证明MCTSr算法在复杂推理任务中的显著优势,尤其是在奥林匹克数学竞赛题目中的表现提升。

7.2 对未来工作的展望

尽管MCTSr算法在解决复杂数学问题上取得了显著进展,其潜在的应用场景仍有待进一步探索。未来的研究可以通过以下几个方向进行拓展:

- 黑盒优化问题:研究MCTSr算法在非结构化问题或黑盒优化中的表现,评估其在其他领域的适应性。

- 自驱动对齐任务:探索MCTSr在大型语言模型的自我对齐问题中的应用,以提升模型的自动调整能力。

- 算法组件优化:进一步优化算法的各个组件,特别是自我优化和自我奖励模块,以提高其在不同任务中的通用性和效率。

7.3 最终结论

本文通过MCT Self-Refine(MCTSr)算法展示了如何利用蒙特卡洛树搜索与自我优化机制,增强大型语言模型在复杂推理任务中的表现。实验结果证明,MCTSr算法为LLM在数学推理任务中的应用开辟了新的路径,显著提升了问题解决的成功率和质量。未来的工作将着重于扩展该算法的适用范围和优化其算法组件,以实现更广泛的AI推理任务应用。

8. Prompts in Experiment(实验中的提示词)

本章节列出了在实验中使用的提示词,主要用于自我优化、自我评估和默认应答的生成。这些提示词设计用于引导大型语言模型(LLM)在自我优化和自我评估过程中提升答案质量。

8.1 Self-Refine(自我优化)

在自我优化过程中,模型首先会生成针对当前答案的反馈,指出不足之处。然后根据这些反馈,模型优化其答案。提示词如下:

- 获取反馈(Get Feedback)

USER: 由于我们有一个较弱的答案,你能否提供一个反馈以更好地纠正这个答案?严格分析这个答案并批判指出每一个可能的缺陷,尽量减少每个可能的分数! 让我们一步一步来思考。

- 获取优化后的答案(Get Refined Answer)

USER: 请根据你的反馈优化你的答案。回答应以[推理过程]…[验证]…开始,并以”[最终答案] 答案是[答案公式]”结束。 让我们一步一步来思考。

这些提示词通过引导模型反思现有答案并进行改进,帮助模型在多轮反馈中逐步优化其解答。

8.2 Self-Reward(自我评估)

在自我评估阶段,模型会对自己生成的答案进行评分,并严格执行评分标准,以确保评分的客观性和准确性。提示词如下:

USER: 问题:问题 答案:答案 严格分析和批判这个答案,指出每一个可能的缺陷,尽可能扣除每一个可能的分数!你需要在打分时非常严苛,以确保评分具有权威性,并且永远不要给出满分。 输出一个介于[-100,+100]之间的分数。例如,从-100到+100。 响应格式: [分析]…[分数]…

通过这样的自我评估机制,模型在答案质量上变得更加严格,并避免因不合理的高分而导致的偏差。

8.3 Dummy Answers(默认应答)

在某些情况下,当模型无法得出答案时,会生成一系列默认的应答。这些应答用于处理模型无法解决的问题或无明确答案的情境。提示词如下:

USER: [“我不知道。”, “我不明白这个问题。”, “我不知道如何解决这个问题。”, “对不起,我不知道这个问题的答案。”]

这些应答用于避免模型在没有答案时输出错误或不相关的内容。

通过使用这些提示词,实验可以引导大型语言模型在自我优化和评估过程中更加精准和有效地改进答案质量,从而提升解答的准确性和可靠性。

![Slow Perception: Let’s Perceive Geometric Figures Step-by-step[缓慢感知:让我们逐步感知几何图形]-AI论文](https://assh83.com/wp-content/uploads/2025/01/1-1-360x180.png)

![Large Concept Models:Language Modeling in a Sentence Representation Space[大型概念模型:在句子表示空间中的语言建模]-AI论文](https://assh83.com/wp-content/uploads/2025/01/image-1-360x180.png)

![Cultural Evolution of Cooperation among LLM Agents[大型语言模型代理间合作的文化演化]-AI论文](https://assh83.com/wp-content/uploads/2025/01/image-360x180.png)

![OpenAIo1原理解读:不确定性感知规划增强LLM信息搜索[Uncertainty of Thoughts: Uncertainty-Aware Planning Enhances Information Seeking]-AI论文](https://assh83.com/wp-content/uploads/2024/09/sea-5603352_1280-75x75.jpg)

![Do NOT Think That Much for 2+3=? On the Overthinking of o1-Like LLMs[不要过度思考2+3等于几 在类LLM的过度思考上]-AI论文](https://assh83.com/wp-content/uploads/2025/01/1-2-350x250.png)

![Slow Perception: Let’s Perceive Geometric Figures Step-by-step[缓慢感知:让我们逐步感知几何图形]-AI论文](https://assh83.com/wp-content/uploads/2025/01/1-1-350x250.png)

![Ensembling Large Language Models with Process Reward-Guided Tree Search for Better Complex Reasoning[结合大型语言模型与过程奖励引导的树搜索以提升复杂推理能力]-AI论文](https://assh83.com/wp-content/uploads/2025/01/1-350x248.png)

![Large Concept Models:Language Modeling in a Sentence Representation Space[大型概念模型:在句子表示空间中的语言建模]-AI论文](https://assh83.com/wp-content/uploads/2025/01/image-1-350x250.png)