0.摘要

在书写和对话中,人们有时会停下来思考。尽管以推理为中心的研究通常将推理视为回答问题或完成任务的一种方法,但推理实际上隐含于几乎所有的书面文本中。例如,这适用于证明中没有明确陈述的步骤或对话背后的心智理论。在自我学习推理器(STaR, Zelikman 等,2022)中,模型通过从少量示例中推断出合理的推理过程并学习那些能够得出正确答案的推理方法,从而获得有用的推理能力。这是一种高度受限的场景——理想情况下,语言模型应能够从任意文本中学习推断出隐含的推理过程。

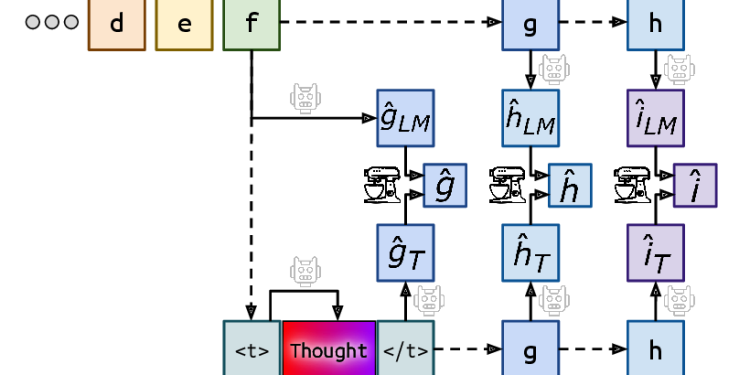

我们提出了Quiet-STaR,这是一种对STaR的扩展,它允许语言模型在生成每个词时为未来文本生成推理过程,从而改进预测。我们解决了几个关键问题,包括:1) 生成连续文本的计算成本,2) 模型最初不知道如何生成或使用内部推理,以及3) 需要预测超出单个下一个词的内容。为此,我们提出了一种基于并行采样的算法,使用可学习的标记指示思维的开始和结束,并采用扩展的教师强制技术。令人鼓舞的是,生成的推理对难以预测的词特别有帮助,并提高了模型直接回答困难问题的能力。特别是在对网络文本语料库进行进一步预训练后,我们在GSM8K数据集(从5.9%提高到10.9%)和CommonsenseQA数据集(从36.3%提高到47.2%)上实现了零样本改进,并观察到自然文本中难以预测的词的困惑度有所改善。关键是,这些改进无需对这些任务进行微调。Quiet-STaR 标志着语言模型朝着更通用、更可扩展的推理学习迈出的重要一步。

1. Introduction(简介)

该论文的引言部分(虽然未直接以“引言”为标题列出,但可以从论文的开头部分进行推断)主要阐述了以下几个关键点:

1.1. 人类思考与表达的习惯

- 人们在写作和交谈时,有时会停下来思考。这种思考过程对于产生合理、有条理的输出至关重要。

1.2. 语言模型的学习现状

- 当前的语言模型(Language Models,LMs)在问答(Question Answering,QA)等任务中,通常是通过从少量示例中推断出理性依据(rationales)来学习有用的思考方式。这种方式是高度受限的,因为它依赖于精心策划的问答数据集。

- 理想情况下,语言模型应该能够推断出任意文本中未明确表述的理性依据。然而,现有的训练方式限制了模型在推理任务上的可扩展性和泛化能力。

1.3. Quiet-STaR 框架的提出

- 针对上述问题,论文提出了Quiet-STaR框架,它是STaR框架的一种泛化。在Quiet-STaR中,语言模型学习在每次输出文本之前先生成理性依据(即“思考”过程),然后将这些理性依据与未来的文本预测相结合(即“表达”过程),并使用REINFORCE算法来学习生成更好的理性依据(即“学习”过程)。

- 这种框架旨在使语言模型能够更灵活地推断出文本中的理性依据,并提高其推理能力。

1.4. 论文的研究贡献

- 论文通过提出Quiet-STaR框架,为语言模型学习推理提供了一种新的方法。

- 论文还通过实验验证了Quiet-STaR框架的有效性,展示了它在多个推理任务上的优越性能。

综上所述,引言部分主要介绍了人类思考与表达的习惯、当前语言模型在学习推理方面存在的问题以及论文提出的Quiet-STaR框架的研究背景和贡献。这为后续章节的详细解读提供了基础。

2. Related Work(相关工作)

在“相关工作”部分(同样,虽然未直接以该标题列出,但可以从论文对过往研究的讨论中推断出来),论文主要回顾和分析了与本研究领域相关的先前工作。以下是对该部分的详细解读:

2.1. 语言模型中的推理

- 论文首先指出了在语言模型中进行推理研究的重要性。先前的研究已经表明,通过训练语言模型来模拟人类的推理过程,可以使其更好地解决复杂任务。

- 提及了一些具体的研究工作,如Rajani等人(2019)的研究,他们展示了通过微调预训练语言模型来输出人类推理轨迹,从而改进其在多项选择题上的表现。

2.2. 训练语言模型进行推理的方法

- 论文概述了训练语言模型以提高其推理能力的不同方法。其中一种方法是通过挖掘推理轨迹或类似推理的数据来训练语言模型(Rajani et al., 2019; Wei et al., 2021a; Lewkowycz et al., 2022; Chung et al., 2022; Gunasekar et al., 2023)。

- 另一种方法是使用迭代训练,即让语言模型基于其先前的推理来生成新的推理,并据此进行训练,如Self-Taught Reasoner(Zelikman et al., 2022)所示。这种方法表明,语言模型可以通过迭代训练来解决越来越复杂的问题。

2.3. STaR及其局限性

- 论文特别提到了STaR(Self-Taught Reasoner)框架,这是一个先前的研究工作,它让语言模型通过迭代训练来学习推理。然而,STaR框架主要依赖于精心策划的数据集,这限制了其推理能力的泛化性和可扩展性。

- 论文指出,虽然STaR等框架在特定任务上取得了显著成果,但它们仍然面临如何在不同任务和文本中泛化推理能力的挑战。

2.4. 其他相关工作

- 除了上述直接针对语言模型推理的研究外,论文还提到了其他相关工作,如使用meta-tokens来压缩长提示以提高效率(Li et al., 2023; Jung & Kim, 2023),以及使用暂停令牌(pause tokens)作为约束版本的Quiet-STaR来改进语言模型的推理能力(Goyal et al., 2023)。

- 这些工作虽然与Quiet-STaR的具体实现不同,但都为改进语言模型的推理能力提供了有价值的见解和方法。

综上所述,“相关工作”部分主要回顾了与本研究领域相关的先前工作,分析了不同训练语言模型进行推理的方法,并指出了STaR框架的局限性以及其他相关工作的贡献。这为后续介绍Quiet-STaR框架提供了背景和对比。

![Slow Perception: Let’s Perceive Geometric Figures Step-by-step[缓慢感知:让我们逐步感知几何图形]-AI论文](https://assh83.com/wp-content/uploads/2025/01/1-1-360x180.png)

![Large Concept Models:Language Modeling in a Sentence Representation Space[大型概念模型:在句子表示空间中的语言建模]-AI论文](https://assh83.com/wp-content/uploads/2025/01/image-1-360x180.png)

![Cultural Evolution of Cooperation among LLM Agents[大型语言模型代理间合作的文化演化]-AI论文](https://assh83.com/wp-content/uploads/2025/01/image-360x180.png)

![OpenAI o1大模型原理解读:自博弈Self-play强化学习方法[A Survey on Self-play Methods in Reinforcement Learning]-AI论文](https://assh83.com/wp-content/uploads/2024/09/3-Figure1-1-75x75.png)

![Do NOT Think That Much for 2+3=? On the Overthinking of o1-Like LLMs[不要过度思考2+3等于几 在类LLM的过度思考上]-AI论文](https://assh83.com/wp-content/uploads/2025/01/1-2-350x250.png)

![Slow Perception: Let’s Perceive Geometric Figures Step-by-step[缓慢感知:让我们逐步感知几何图形]-AI论文](https://assh83.com/wp-content/uploads/2025/01/1-1-350x250.png)

![Ensembling Large Language Models with Process Reward-Guided Tree Search for Better Complex Reasoning[结合大型语言模型与过程奖励引导的树搜索以提升复杂推理能力]-AI论文](https://assh83.com/wp-content/uploads/2025/01/1-350x248.png)

![Large Concept Models:Language Modeling in a Sentence Representation Space[大型概念模型:在句子表示空间中的语言建模]-AI论文](https://assh83.com/wp-content/uploads/2025/01/image-1-350x250.png)